Il 16 luglio 1945, nel deserto del New Mexico, il Trinity Test segnò l’alba dell’era atomica, un momento epocale raccontato anche nel recente film Oppenheimer. Quella detonazione non solo cambiò il corso della storia per gli sviluppi bellici, ma contaminò per sempre l’ambiente con particelle radioattive. Secondo alcuni accademici, un evento simile è accaduto nel mondo digitale il 30 novembre 2022: il lancio di ChatGPT di OpenAI.

L’affermazione, forte e quasi apocalittica, paragona l’impatto di ChatGPT a quello della prima bomba atomica, non per il suo potenziale distruttivo, ma per una conseguenza più subdola e permanente: l’inquinamento dei dati.

L’acciaio a bassa contaminazione

Dopo il 1945, i metalli prodotti iniziarono a contenere tracce di radioattività a causa del fallout nucleare, rendendoli inadatti per strumenti scientifici di precisione e le apparecchiature mediche. Per queste applicazioni, divenne necessario trovare il cosiddetto “acciaio a bassa radioattività” (low-background steel), ovvero acciaio prodotto prima dell’era atomica. Una delle fonti più preziose divenne la flotta navale tedesca che l’ammiraglio Ludwig von Reuter autoaffondò nel 1919, molto prima che l’atomo venisse scisso. Maurice Chiodo, ricercatore a Cambridge, arriva a dire che quell’ammiraglio diede “il più grande contributo alla medicina nucleare del mondo” fornendo questa riserva enorme di metallo “pulito”.

La contaminazione dei dati

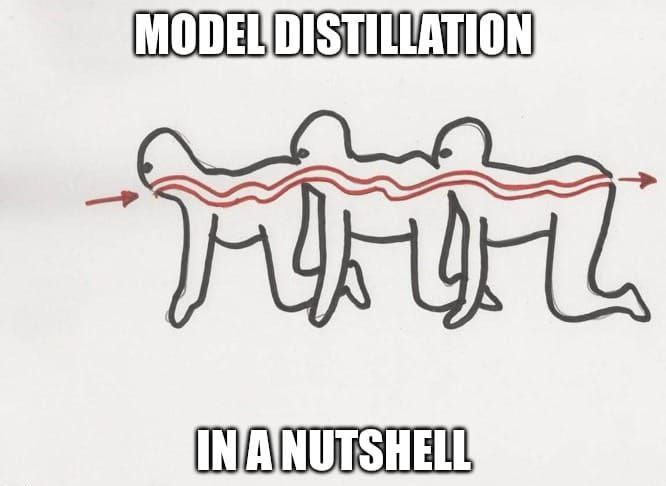

La preoccupazione principale è un fenomeno noto come “AI model collapse” o “Model Autophagy Disorder” che si verifica quando i modelli di IA vengono addestrati su dati sintetici prodotti da altri modelli di IA. In pratica, i modelli “si nutrono della propria produzione“, portando a un degrado delle loro capacità.

Nell’analogia con l’acciaio, i dati “puliti” sono quelli creati da esseri umani prima del 2022. La versione pre-atomica!

La preoccupazione non riguarda solo il fatto che un’IA possa produrre informazioni false. Il problema più grave riguarda il potere.

Le grandi aziende tecnologiche che hanno sviluppato i primi modelli di IA hanno avuto il tempo di “aspirare” enormi quantità di dati “puliti” dal web, creati interamente da esseri umani. Ora che il web è sempre più saturo di contenuti sintetici, le startup e i futuri sviluppatori faranno una fatica enorme a trovare dataset di alta qualità e non contaminati o comunque sarà proibitivamente costoso o probabilmente impossibile ripulirli.

Come per l’era atomica, il lancio di ChatGPT potrebbe aver segnato un punto di non ritorno, lasciandoci in un mondo in cui la distinzione tra il creato dall’uomo e il sintetizzato dalla macchina diventa sempre più labile, con conseguenze che stiamo solo iniziando a comprendere.

Disclaimer

Questo contenuto non è ovviamente scritto da un umano 😉